La automática la define el diccionario de la Real Academia Española (RAE) como la ciencia que trata de sustituir en un proceso el operador humano por dispositivos mecánicos o electrónicos.

El término control tiene muchos significados dependiendo de la comunidad donde se aplique. Desde la perspectiva de la automática y siguiendo también la definición del RAE, hace referencia a la regulación, manual o automática, sobre un sistema. Esta regulación tiene por objeto conseguir unas condiciones determinadas de funcionamiento del sistema bajo control. Por tanto, y desde el punto de vista de esta asignatura, el término control incluye lazos de realimentación en amplificadores electrónicos, controladores de puntos de consigna en procesos químicos, ordenadores de vuelo de aviones, controladores de tráfico en Internet (routers), etc. El concepto de control va acaparando cada vez aplicaciones más sofisticadas y novedosas en los campos de vehículos y robots autónomos, sistemas biológicos, cirugía, tele-asistencia, economía, etc.

En la Figura 1.1 se muestra el esquema de un sistema controlado por computador. El cuadro superior en línea discontinua representa la dinámica del proceso (quiere decir el conjunto de ecuaciones que reflejan su comportamiento temporal) que se quiere controlar. Los actuadores (también denominados accionadores) son los elementos (usualmente de potencia: motores, electroválvulas, etc.) que actúan sobre el sistema condicionando su funcionamiento. El sistema bajo control o planta (en control, al sistema a controlar se le suele denominar planta) está representado por su modelo dinámico (modelo matemático escrito de forma adecuada para poder aplicar las técnicas de Ingeniería de Control). A la salida de la planta los sensores miden el estado de las variables que han de ser controladas (presión, temperatura, velocidad, etc.). Tanto el ruido en la actuación y la medida (el ruido es en general una mala concreción en la señal, bien porque está contaminada con ruido interno o externo, o porque no se tiene certeza de su valor y sólo se conoce hasta una precisión) como las posibles perturbaciones sobre la planta (una racha de viento en el control del rumbo de un avión por ejemplo) han de ser consideradas en el proceso de control. En este apartado de ruidos y perturbaciones habría que tener también en cuenta las posibles incertidumbres en la dinámica de la planta (errores en sus parámetros, efectos no modelados, etc.). Es deseable que el sistema de control sea robusto frente a todos estos efectos perniciosos. Esto es, esté preparado para soportarlos.

El cuadro inferior en línea discontinua de la Figura 1.1 representa el controlador. Éste sensa (mide) a la salida de la planta la/s variable/s que se desean tener bajo control. La medida, después de pasar por un filtro para acondicionarla, entra en un convertidor A/D, ya que el algoritmo que realiza el control (ley de control) está implementado en un computador. La señal de control que produce el algoritmo después de analizar la entrada que le ha llegado, se dirige a un convertidor D/A, ya que normalmente los actuadores funcionan con señales analógicas. Nótese que una señal de reloj sincroniza la operación de los convertidores y el procesado en el computador. También hay que tener en cuenta la entrada externa al computador, la cual permite cambiar parámetros y/o consignas en el algoritmo de control.

La palabra clave más importante del control es la realimentación. Nótese en la Figura 1.1 como los cuadros de línea discontinua que representan el proceso y el controlador están interconectados, de modo que la salida del primero se usa como entrada del segundo, creando de este modo un sistema en lazo cerrado.

|

| Figura 1.1 |

El concepto central en control es el lazo de realimentación medida – computación – actuación. El primer objetivo a conseguir mediante el control es que la dinámica del sistema en lazo cerrado sea estable. Esto es, las perturbaciones acotadas han de producir como mucho errores acotados. Garantizada la estabilidad del sistema en lazo cerrado, el controlador ha de proveer otras características deseables como por ejemplo: respuesta rápida ante cambios en los puntos de consigna, rechazo o buena atenuación a las perturbaciones, etc. Las propiedades del controlador se establecen a partir de una amplia variedad de técnicas de modelado, análisis y síntesis, las cuales veremos durante el curso. Estas técnicas permiten capturar lo esencial de la dinámica del sistema así como explorar comportamientos del mismo en presencia de incertidumbres, ruido o fallos en los componentes.

La Ingeniería de Control es una disciplina de la ciencia que está muy conectada con otras que usa como herramientas: física (dinámica y modelado), matemáticas (algoritmia, análisis matemático, álgebra), computación (información y software), investigación operativa (optimización, probabilidad, teoría de juegos). No obstante lo anterior, debe quedar claro que tanto los objetivos como la aproximación al problema y su resolución son muy diferentes en la Ingeniería de Control respecto de las disciplinas anteriores.

Hoy en día, debido fundamentalmente a que las leyes de control se implementan en un computador (implementación software), el control y la ciencia de la computación están muy relacionados, sin embargo, debe quedar claro que tanto los algoritmos como el propio software son muy diferentes, debido a los requerimientos de la dinámica del sistema y a la naturaleza de implementaciones en tiempo real.

|

| Figura 1.2 |

La realimentación tiene una serie de propiedades muy interesantes y útiles. Así por ejemplo permite diseñar sistemas precisos a partir de elementos imprecisos, estabilizar un sistema inestable o minimizar las perturbaciones externas sobre un sistema. A continuación se va a realizar un breve recorrido sobre ejemplos ilustrativos de a influencia de la realimentación en la consecución de hitos de control.

Primeros ejemplos tecnológicos

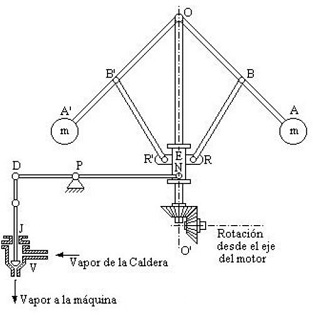

La proliferación de sistemas de control en la vida cotidiana ocurrió sobretodo a partir de la mitad de los años 50 del siglo pasado. No obstante, existen ejemplos aislados acontecidos mucho antes, como por ejemplo el regulador centrífugo o de bolas (inventado por el ingeniero inglés J. Watt en 1788, por lo que es también conocido como regulador de Watt), el cual (ver Figura 1.2) emplea la fuerza centrífuga originada por la velocidad de giro de las bolas del contrapeso para deslizar por un eje el mecanismo que acciona la válvula de admisión de vapor. Nótese como al estar obturado el vapor a la máquina ésta disminuirá la velocidad de rotación del eje del motor, lo cual hará que las bolas giren más despacio y tiendan a caer. Entonces, el casquillo que se desplaza por el eje será empujado hacia abajo dejando de obturar el paso de vapor a la máquina, con lo cual esta aumentará de nuevo su velocidad de giro. El regulador centrífugo es pues un controlador de la velocidad de giro de la máquina de vapor.

|

|

| (a) | (b) |

| Figura 1.3 | |

Otro ejemplo que, aunque más moderno que el anterior, es de finales del siglo XX, es el termostato utilizado para regular la temperatura de una vivienda, el cual fue inventado por Albert Butz en 1885 y cuya explotación comercial dio lugar a la compañía Honeywell. En la Figura 1.3 (a) puede verse un termostato de Honeywell del año 1953. En la Figura 1.3 (b) se muestra un termostato analógico de los más usuales que aún hoy pueden verse en edificios. Su funcionamiento está basado en la propiedad que presentan los metales de dilatarse al aumentar la temperatura. Se coloca un fleje con dos láminas unidas de dos metales con diferente coeficiente de dilatación (cobre e hierro por ejemplo). Cuando la temperatura aumenta, la lámina que se dilata más (en este caso la de cobre) se curva, ya que necesita más espacio, con lo cual se separan los contactos del fleje y se abre el circuito eléctrico. Esto detiene el sistema de calefacción hasta que la temperatura baje, el metal se contraiga, el fleje se estire y, como consecuencia, se cierre el circuito eléctrico que activa de nuevo la calefacción. Respecto del concepto de controlador, la lámina bimetálica actúa como tal y como sensor, ya que a partir de una temperatura de consigna fijada por el usuario mediante el mando (curvatura del fleje), el sistema la compara con la de la habitación a controlar (variable de salida); cuando hay diferencia se genera una señal de error que es realimentada para generar una señal de mando (control) que enciende o apaga la calefacción. Aunque el funcionamiento del termostato captura la esencia del control mediante realimentación, su mecanismo es demasiado simple e imperfecto (aunque útil), ya que existen retardos entre el sensor y la planta a controlar (habitación). Los termostatos de calidad actuales se anticipan apagando o encendiendo la calefacción antes que la señal de error cambie de signo, lo cual evita saltos de temperatura grandes así como ciclos de funcionamiento elevados de la máquina. Esta interacción entre la dinámica del proceso (la velocidad de calentamiento o enfriamiento de la habitación) y la operación del controlador es un elemento clave en el diseño de los sistemas de control actuales.

Con el transcurso del siglo XX se fueron desarrollando sistemas de control cada vez más sofisticados, como por ejemplo el control de crucero o controlador de velocidad para vehículos. Éste fue inventado en 1945 por el inventor ciego e ingeniero mecánico Ralph Teetor (ver Figura 1.4). Su idea nació de la frustración de ir en el vehículo con su abogado, quien frenaba y aceleraba continuamente según hablaba. El primer vehículo con el sistema de Teetor fue el Chrysler Imperial en 1958. Este sistema calculaba la velocidad sobre la carretera basándose en las rotaciones de un palier y usaba una bobina para variar la posición del acelerador según fuera necesario. Hoy en día los automóviles son quizás los sistemas que, siendo más cercanos al gran público, están dotados de más sistemas de control (control de crucero adaptativo1 [1] , control de tracción2 [2] , control de estabilidad3 [3] , control de emisión de gases, etc.).

| Figura 1.4 |

Generación y transporte de energía eléctrica

El control es una misión crítica en los sistemas de producción y transporte de energía eléctrica, de modo que las centrales eléctricas están dotadas de multitud de lazos de control para garantizar su correcto funcionamiento. El control es fundamental también en el transporte de la electricidad, ya que ésta ha de ser llevada hasta el último rincón donde es necesaria y con la potencia adecuada, pero la energía eléctrica tiene muy difícil almacenaje, con lo cual hay que adecuar lo más posible la generación al consumo. La gestión de la energía en la red eléctrica es un problema de control sencillo de resolver cuando hay un solo generador y un consumidor (caso de una vivienda aislada que se genera su propia electricidad por paneles fotovoltaicos por ejemplo), pero es muy complejo es un sistema altamente distribuido, donde hay muchos generadores, muchos más consumidores y largas distancias entre ellos. Para añadir aún más complejidad al problema del control de la red eléctrica, hay que tener en cuenta que la demanda en un punto o varios a la vez puede cambiar de forma rápida e impredecible. En la Figura 1.5 se muestra a modo de ejemplo el sistema eléctrico (enero de 2009) en alta tensión que circunda la ciudad de Huelva. En color rojo se dibujan las líneas de 400 KV, en verde las de 220 KV, en azul las de 132/110 KV y, en negro, las de menos de 110 KV. Las líneas discontinuas, sean del color que sean, representan líneas programadas o en construcción de la tensión correspondiente al color. Los puntos gruesos de color negro representan subestaciones eléctricas (al lado de las centrales sirven para elevar la tensión antes de transportarla, y al lado de las poblaciones para reducir la tensión con objeto de poder usarla), y los cuadros representan las centrales con su capacidad de producción en MW. Los rellenos de negro las térmicas clásicas, los que tienen la mitad rellena de negro eólicas y los de la mitad diagonal rellena de negro de ciclo combinado. El control del sistema eléctrico exige adecuar la producción de las centrales a las necesidades de los clientes (cargas) pasando por las subestaciones.

Caídas de árboles sobre líneas, vientos, rayos, fallos en equipos, etc., pueden ocasionar perturbaciones graves en el sistema eléctrico, por ello, deben haber sofisticados sistemas de control que eliminen o minimicen sus consecuencias para el usuario final. Dependiendo de la gravedad de la perturbación los diferentes niveles del control del sistema eléctrico actuarán reduciendo la tensión, dividiendo una red en subredes, desconectando líneas y usuarios, etc. El sistema eléctrico es pues un buen ejemplo de lo complicado que puede llegar a ser un sistema de control.

|

| Figura 1.5 |

|

| Figura 1.6 Fotografía original del primer vuelo con motor de la historia. A los mandos Orville Wright; a la derecha, su hermano Wilbur. 17 de diciembre de 1903. El vuelo fue sobre las playas de Kitty Hawk, Carolina del Norte. El aparato, en su primer despegue, recorrió 36 metros en 12 segundos. |

Aerospacial

La consecución de un control adecuado fue probablemente la llave que permitió a los hermanos Wright hacer volar un aparato a principios del siglo XX (ver Figura 1.6). De hecho, los hermanos Wright no se hicieron famosos por demostrar simplemente el vuelo con motor, sino por demostrar el vuelo con motor controlado. Su primer aeroplano incorporaba ya superficies de control (aletas verticales y alas de pato4 [4] ) así como alas adaptables que permitían al piloto controlar el vuelo. Realmente, un avión en vuelo es un sistema que tiende a hacerse inestable, con lo cual se necesita un sistema de control (el piloto cuando el vuelo es manual) que actúe de forma constante para que no caiga. A este primer vuelo controlado de 1903 le han seguido 100 años de éxitos continuos en la mejora de los sistemas de control de los aviones, los cuales han dado lugar a los aparatos comerciales y militares de hoy en día (ver Figura 1.7). En la Figura 1.7 (a) se muestra el Eurofighter, nacido de un consorcio anglo/alemán/italo/español. Es un avión de una maniobrabilidad extraordinaria (obsérvense sus alas de pato y de delta truncadas), para lo cual se diseñó inherentemente inestable; un cuádruple sistema de control digital da una estabilidad artificial al estar ajustando constantemente las superficies de control (Fly-by-wire5 [5] ). En la Figura 1.7 (b) se muestra el X-45 UCAV (Unmanned Combat Air Vehicle), un avión militar no tripulado estadounidense apto para volar a match 0,85 y capaz de transportar misiles. Tanto su longitud total como envergadura de alas están en torno a los 11 metros.

|

|

| (a) | (b) |

| Figura 1.7. Aviones militares modernos. (a) Eurofighter Typhoon. (b) Avión no tripulado X-45 J-UCAV. | |

El sector espacial es una de las puntas de lanza del desarrollo investigador en el ámbito del control, de hecho la carrera espacial tanto rusa como norteamericana han marcado hitos tecnológicos que luego han sido de aplicación a otros campos. Uno de los grandes retos científicos que afrontó la NASA desde mediados de los años 60 fue disponer de un transbordador espacial. Esto lo consiguió el 12 de abril de 1981 con el lanzamiento del primer sistema de transbordador espacial (en inglés: Space Transport System, STS o Space Shuttle), el Columbia (ver Figura 1.8 (a). Actualmente el uso del transbordador espacial está concentrado totalmente en el ensamblaje de la Estación Espacial Internacional (en inglés: International Space Station, ISS). El tiempo de vida de transbordadores espaciales de esta clase se espera que acabe a finales de 2010. Para entonces deberán ser substituidos por el vehículo Orion norteamericano y/o la nave rusa Kliper, de mucho menor coste que los transbordadores espaciales norteamericanos.

En este apartado merece un lugar especial la sonda espacial Voyager I, la cual fue lanzada el 5 de septiembre de 1977 y gracias a que ha superado con creces sus perspectivas iniciales de vida útil (fue diseñada inicialmente para visitar Júpiter y Saturno) es hoy en día el objeto hecho por el hombre más alejado de la Tierra. De hecho está atravesando la Heliopausa6 [6] a más de 16.000 millones de kilómetros del Sol. Cuando la Voyager I sobrepase la Heliopausa será el primer objeto de fabricación humana que abandone nuestro sistema estelar. Entonces los científicos obtendrán las primeras mediciones directas de las condiciones del espacio interestelar, las cuales podrían proveer pistas relevantes del origen y la naturaleza del universo. A esta distancia, las señales del Voyager I tardarán más de quince horas en alcanzar el centro de control en la Tierra. Voyager 1 tiene una trayectoria parabolica, y ha alcanzado velocidad de escape, lo que significa que su orbita no regresará nunca al Sistema solar interior. Esto es, vagará eternamente por el espacio enviando señales a la Tierra hasta que su sistema de energía se agote (sobre el año 2.025).

|

|

| (a) | (b) |

| Figura 1.8. Ingenios espaciales. (a) Lanzamiento del Columbia en 1981. (b) Sonda espacial Voyager I lanzada el 5 de septiembre de 1977. | |

Materiales y transformación

La industria química es responsable del auge considerable en el desarrollo de nuevos materiales, lo cual es clave en el desarrollo de nuestra sociedad. Además, tal como el nivel de exigencia de ésta aumenta, se hace necesario mejorar cada vez más la calidad de los productos fabricados minimizando todo tipo de riesgos, como los medioambientales por ejemplo, lo cual obliga a controles cada vez más precisos en esta industria7 [7]. Por otro lado, los procesos productivos se requieren que sean cada vez más eficientes energéticamente, lo cual ha dado lugar a los procesos de cogeneración8 [8]. Cada nuevo requerimiento añade complejidad al sistema de control de la planta industrial, creando en su proceso de diseño un nuevo desafío. En la Figura 1.9. se observa el proceso conocido como Epitaxia por haces moleculares que permite fabricar estructuras con precisión de unos pocos Angstroms (en un centímetro caben 10 millones de angstroms). Esta técnica es usada en el crecimiento de heteroestructuras de semiconductores por la gran perfección cristalina que alcanza. Los haces moleculares inciden sobre un sustrato y diversas reacciones químicas ocasionan la deposición de monocapas sucesivas. Mediante el adecuado control de las especies químicas de los haces se puede variar la composición de las capas epitaxiales. Los requerimientos técnicos son elevados pues se exige un perfecto control de la temperatura y vacío en la cámara de crecimiento.

| (a) | (b) |

| Figura 1.9. Epitaxia por haces moleculares. (a) Deposición de capas con absoluta precisión. (b) Cámara para crecimiento epitaxial. | |

Puesto que el sensor es un elemento fundamental en los sistemas de control, las nuevas tecnologías de desarrollo de sensores están proporcionando nuevas oportunidades en el desarrollo de controladores. Sensores con conexión directa al computador (controlador) de aplicación en láser backscattering9, vídeo microscopía, espectroscopía infrarroja y de Raman10, etc., están propiciando que procesos hasta ahora de laboratorio se estén incorporando al mundo industrial.

Robótica y máquinas inteligentes

El objetivo de la ingeniería cibernética, ya establecido en los años 40 e incluso antes, ha sido implementar sistemas capaces de exhibir respuestas muy flexibles o inteligentes ante cambios en la situación. De hecho, según la RAE, la cibernética estudia las analogías entre los sistemas de control y comunicación de los seres vivos y los de las máquinas; y en particular, el de las aplicaciones de los mecanismos de regulación biológica a la tecnología. Esto es, la cibernética está completamente ligada al control, y ambas disciplinas han sentado las bases de la robótica moderna.

Dos logros importantes en este ámbito son los Mars Exploratory Rovers y los robots de entretenimiento como el AIBO de Sony, los cuales se muestran en la Figura 1.10. Los Mars Exploratory Rovers han sido desarrollados por el Jet Propulsion Laboratory (JPL) y han estado maniobrando en la superficie de Marte durante más de 4 años, a partir de enero de 2004, enviando medidas y fotos de su entorno de trabajo. El robot AIB de Sony, lanzado al mercado en 1.999, fue el primer robot de entretenimiento lanzado en masa al mercado. Es digno de mencionar el uso que hacía de técnicas de inteligencia artificial que le permitían reaccionar ante estímulos según su propio juicio. Este altísimo nivel de realimentación es un elemento clave en robótica, donde cuestiones como el evitar obstáculos, seguir trayectorias, aprendizaje o autonomía son muy relevantes.

A pesar de los enormes progresos acontecidos en los últimos años en el campo de la robótica, en muchos aspectos está todavía en la infancia. Los robots de hoy en día exhiben comportamientos muy simples comparados con los humanos, y sus habilidades para moverse, interpretar señales externas complejas, realizar razonamientos de alto nivel y cooperar juntos en equipo son muy limitadas. Sin duda la combinación de técnicas de inteligencia artificial (planificación, adaptación y aprendizaje) con técnicas de control contribuirá a realizar mejoras continuas en los campos citados.

|

|

| (a) | (b) |

| Figura 1.10. Sistemas robóticos. (a) Spirit, uno de los dos robots exploradores de Marte que aterrizó en él en enero de 2004. (b) Robot AIBO de Sony, uno de los primeros robots de entretenimiento comercializados en masa. Aunque los dos sistemas robóticos tiene cometidos muy diferentes, ambos hacen uso de realimentación entre sensores, actuadores y de computación para funcionar en entornos desconocidos. | |

Redes y sistemas informáticos

El control de redes es una gran área de investigación que abarca muchos tópicos incluyendo el control de congestión de tráfico, enrutado, copiado de datos y gestión de energía. Varias características de estos problemas de control los hacen muy interesantes. La característica dominante en todos ellos es la enorme escala de los sistemas que han de ser controlados; Internet es probablemente el mayor sistema de control realimentado que la humanidad ha construido nunca. Otra característica es la naturaleza descentralizada del problema de control: las decisiones deben ser tomadas muy rápidamente y basándose sólo en información local. La estabilidad en Internet es muy complicada debido a los retardos de tiempo variable que se producen, con lo cual la información sobre la red puede ser observada o enviada a los controladores sólo después de un retardo, con lo cual la acción de control sobre la red se produce con un retraso considerable. Incertidumbres y variaciones en la red, cambios en su topología, características del canal de transmisión, demanda de tráfico y recursos disponibles están cambiando continuamente y en forma impredecible.

El control de las redes está también íntimamente relacionado con el control de los servidores que están conectados a ellas. Los computadores son los elementos claves de los routers, servidores web y servidores de bases de datos usados para comunicaciones, comercio electrónico, publicidad y almacenamiento de la información. Mientras que los costes de hardware (la electrónica) han disminuido de forma considerable, los de operación de estos sistemas han aumentado, debido a la dificultad en su gestión y mantenimiento, como consecuencia del grado de complejidad cada vez más acusado.

En la Figura 1.11 (a) se muestra un ejemplo de un sistema multicapas para e-comercio. El sistema tiene varias capas de servidores. La capa de cabecera acepta solicitudes entrantes y las enruta hacia la de servidores http, los cuales las distribuyen hacia los servidores de aplicaciones. El tratamiento de las solicitudes entrantes puede variar en un amplio rango, y los servidores de aplicaciones pueden acceder también a otros servidores externos gestionados por otras organizaciones.

El control de un servidor individual en una capa se muestra en la Figura 1.11 (b). Una cantidad que representa la calidad del servicio o el coste de la operación –tal como tiempo de respuesta, tasa de transferencia, servicio de atención al cliente o uso de memoria– se mide en el computador. Las variables de control pueden representar mensajes entrantes aceptados, prioridades en el sistema operativo o asignación de memoria. El lazo de realimentación ha de encargarse entonces de mantener las variables que representan la calidad del servicio dentro del rango de valores fijado.

| (a) | (b) |

| Figura 1.11. Ejemplo de sistema multicapas para servicios de Internet. (a) Los usuarios solicitan información desde un conjunto de computadores (capa 1), la cual a su vez recoge información de otros computadores (capas 2 y 3). (b) Cada servidor individual tiene un conjunto de parámetros de referencia fijados por el operador (humano) del sistema. La realimentación permite además operar al sistema en presencia de incertidumbres. | |

Economía

La economía es un sistema dinámico muy grande con muchos actores: gobiernos, organizaciones, compañías y particulares. Los gobiernos controlan la economía mediante leyes y tasas, los bancos centrales fijando el tipo de interés y las compañías estableciendo precios y realizando inversiones. Las personas particulares controlan la economía mediante compras, ahorros e inversiones. Se han realizado esfuerzos enormes para modelar el sistema tanto a nivel macro11 [9] como microeconómico12 [10] , pero el modelado es muy complicado, ya que el sistema está muy interrelacionado y, por tanto, muy influenciado por el comportamiento dentro de él de los diferentes actores.

J. M. Keynes desarrolló en 1936 un modelo simple para comprender relaciones entre producto nacional bruto, inversión, consumo y gasto público. Una de las observaciones de Keynes fue que bajo ciertas condiciones, por ejemplo durante la gran depresión de los años 30, un incremento en el gasto público podría llevar a un gran aumento en el producto nacional bruto. Esta idea fue usada por varios gobiernos con objeto de aliviar los efectos de la gran depresión. Las ideas de Keynes serán modeladas en el capítulo siguiente.

Una de las razones de porqué es muy difícil modelar sistemas económicos es que éstos no están sometidos a leyes de conservación. Un ejemplo típico es el valor en bolsa de una empresa, el cual puede cambiar rápida y erráticamente. No obstante lo anterior, sí hay áreas concretas con leyes de conservación que sí permiten elaborar modelos precisos. Un ejemplo es el flujo de productos desde un fabricante a un minorista tal como se ilustra en la Figura 1.12. Los productos son cantidades físicas que obedecen una ley de conservación, y el sistema puede ser modelado considerando las unidades de producto en los diferentes inventarios. El control de las cadenas de producción y consumo origina importantes beneficios económicos, ya que minimiza la cantidad de producto almacenado.

Los problemas reales son más complejos de lo que indica la Figura 1.11, ya que puede haber muchos productos diferentes, muchas fábricas distribuidas geográficamente y además éstas pueden requerir materias primas o productos semielaborados.

El control de las cadenas de producción y suministro fue propuesto por J. W. Forrester en 1961 y es hoy en día de gran importancia, ya que los beneficios económicos que se obtienen minimizando inventarios son considerables. Los modelos para reducir inventarios han sufrido un auge enorme gracias al uso de las tecnologías de la información y las comunicaciones, las cuales han permitido predecir ventas, seguir la pista de productos y ajustar en consecuencia la producción justo a tiempo13 [11]. Este control de las cadenas de producción y suministro ha proporcionado éxitos notables de distribuidores a nivel mundial (piénsese por ejemplo en las grandes cadenas de hipermercado, comida rápida, tiendas de moda franquiciadas, etc.) La publicidad en Internet es una aplicación emergente de control. Advertising on the Internet is an emerging application of control. La publicidad basada en redes permite medir los efectos de las diferentes estrategias de comercialización. Las respuestas de los consumidores pueden ser modeladas, lo cual permite elaborar estrategias de realimentación.

| Figura 1.12. Dinámica de la cadena de suministro. Los productos van desde el fabricante al cliente a través de distribuidores y detallistas tal como indican las líneas sólidas. Nótese los múltiples lazos de realimentación creados por las líneas discontinuas, los cales son originados porque cada agente trata de mantener su propio nivel de inventario. |

Industria farmacéutica

La industria farmacéutica ha tenido un desarrollo espectacular a partir de la mitad del siglo XX, cuando los medicamentos han comenzado ha llegar en masa a la población en general, y el acceso a ellos se ha convertido en algo rutinario para el ciudadano de los países desarrollados. Hoy en día la industria farmacéutica tiene ante sí grandes retos para resolver problemas de salud que azotan la humanidad: cáncer, sida, cardiopatías, etc. Por ello, las inversiones en desarrollo de medicamentos son enormes y, en consonancia, lo son también la complejidad de los laboratorios y las técnicas utilizadas. Un ejemplo de esto puede ser la industria biofarmacéutica, y dentro de ella la producción industrial de anticuerpos monoclonales14 [12] (MAB), debido a sus aplicaciones tanto diagnósticas como clínicas. Este es un campo que se encuentra actualmente en pleno desafío investigador y tecnológico.

Concretando aún más en el ejemplo, hay un gran número de complicaciones que dificultan la producción industrial de la célula hybridoma15, por ello el control industrial actual del cultivo de esta célula se realiza de forma manual. Las complicaciones que surgen para realizar un control automático radican en los requerimientos tan estrictos que exigen el crecimiento de los cultivos, la ausencia de medidas en línea de substratos esenciales en el proceso, la escasez de datos experimentales precisos, así como la dinámica extremadamente compleja del proceso. Con objeto de considerar todas las variables del proceso y la interacción entre ellas, a escala industrial se tiende a integrar el modelado, el diseño del experimento y la validación, el control y la optimización en un mismo sistema (ver Figura 1.13) que permita incrementar la productividad, regular la calidad del producto y reducir costes.

| Figura 1.13. |

Realimentación en la naturaleza

El desarrollo de metodologías rigurosas que permitan modelar el comportamiento de sistemas naturales complejos (debido a la interacción de multitud de sistemas, la mayoría de las veces muy simples, pero con intrincados patrones de flujo de información) es un aspecto de la dinámica de sistemas16 [13]. Los avances que se están produciendo en ciencia y tecnología están permitiendo concebir una comprensión más amplia en el comportamiento (dinámica) de sistemas complejos que se dan en la naturaleza. Por poner sólo algunos ejemplos:

Sistemas biológicos. Hay un interés enorme en conocer de forma fehaciente los mecanismos que se dan a nivel celular (ver en la Figura 1.14 el caso particular de las metaloproteínas17 [14]), no sólo por el hecho de utilizar este conocimiento a nivel médico para curar enfermedades, sino, como vimos en el apartado anterior, para producir medicamentos, sustancias, células, etc., a nivel industrial. Hay una gran variedad de fenómenos biológicos que proporcionan una fuente amplia de ejemplos de control, incluyendo regulación genética, mecanismos de realimentación hormonal, inmunológica y cardiovascular, control muscular y locomotor; percepción activa, visión y recepción de información sobre la localización del cuerpo, sus movimientos y el sistema sensitivo; atención y conciencia; dinámica de poblaciones y epidemias. Cada una de ellas (y muchas otras más) proporcionan oportunidades para explicar lo que funciona, cómo funciona y qué podemos hacer para afectar su funcionamiento.

| Figura 1.14. Caminos del tráfico de cobre en la célula de un mamífero. Este conocimiento es fundamental para fabricar metaloproteínas. |

Ecosistemas. Un ecosistema es un sistema natural que está formado por un conjunto de organismos vivos (biocenosis) y el medio físico en donde se relacionan (biotopo). Un ecosistema es una unidad compuesta de organismos interdependientes que comparten el mismo hábitat (ver Figura 1.15). Los ecosistemas suelen formar una serie de cadenas que muestran la interdependencia de los organismos dentro del sistema. Los ecosistemas son sistemas dinámicos complejos de múltiples escalas, que proporcionan una nueva y amplia gama de desafíos para el modelado y análisis de sistemas realimentados. La experiencia reciente en la aplicación de técnicas de control y modelado de sistemas dinámicos a las redes de bacterias, sugiere que gran parte de la complejidad de estas redes se debe a la presencia de múltiples capas de lazos de realimentación que proporcionan una funcionalidad robusta a la celda individual. Sin embargo, en otros casos, los acontecimientos a nivel celular benefician a la colonia a expensas del individuo. Análisis a nivel de sistemas se pueden aplicar a los ecosistemas con el objetivo de comprender la solidez de esos sistemas, y la medida en que las decisiones y acontecimientos que afectan a las especies individuales contribuyen a la solidez y/o fragilidad del ecosistema en su conjunto.

| (a) | (b) |

| Figura 1.15. Ejemplo de ecosistemas. (a) Sabana (Tanzania). (b) Arrecife de coral en la Gran Barrera de Coral, el mayor arrecife de coral del mundo, situado en el Mar del Coral, frente a la costa de Queensland al noreste de Australia. | |

Ciencias ambientales. Las Ciencias Ambientales son un área de la ciencia cuyo objetivo principal es buscar y conocer las relaciones que mantiene el ser humano consigo mismo y con la naturaleza. Ya se sabe que las actividades humanas han alterado el medio ambiente a escala mundial. Los investigadores en este ámbito se enfrentan a problemas de enorme complejidad; quizás el primero de ellos es comprender los sistemas de retroalimentación que operan a escala mundial..

Las ciencias ambientales Implican un área de estudio multidisciplinar que abarca distintos elementos. Incluye el estudio de problemas ambientales y la propuesta de modelos para el desarrollo sostenible. Así por ejemplo, las ciencias ambientales estudian la depuración y el tratamiento de aguas (ver Figura 1.16 (a)); esto es, el conjunto de operaciones unitarias de tipo físico, químico o biológico cuya finalidad es la eliminación o reducción de la contaminación o las características no deseables de las aguas, bien sean naturales, de abastecimiento, de proceso o residuales —llamadas, en el caso de las urbanas, aguas negras—. La finalidad de estas operaciones es obtener unas aguas con las características adecuadas al uso que se les vaya a dar, por lo que la combinación y naturaleza exacta de los procesos varía en función tanto de las propiedades de las aguas de partida como de su destino final. Otro ejemplo del campo de las ciencias ambientales es la gestión de residuos. Los residuos no aprovechables constituyen un problema para muchas sociedades, sobre todo para las grandes urbes, así como para el conjunto de la población del planeta, debido a que la sobrepoblación, las actividades humanas modernas y el consumismo, han acrecentado mucho la cantidad de basura que se genera (ver Figura 1.16 (b)); lo anterior junto con el ineficiente manejo que se hace con dichos residuos (quemas a cielo abierto, disposición en tiraderos o vertederos ineficientes), provoca problemas tales como la contaminación, que origina problemas de salud y daño al ambiente, además deprovocar conflictos sociales y políticos.

| (a) | (b) |

| Figura 1.16. Ejemplo de campos de trabajo de las ciencias ambientales. (a) Planta de depuración y tratamiento de aguas. (b) Desechos sólidos caseros clasificados. 1) envases de vidrio, 2) plástico fino, 3) plástico grueso, 4) cartón, 5) varios, 6) latas compactadas, 7) papel, 8) poliestireno, 9) pedacería de vidrio, 10) pilas, 11) metales diversos, 12) orgánicos, 13) tetrapak, 14) telas, 15) sanitarios. | |

La realimentación es una idea o concepto que, tal como se ha visto, es de uso muy extendido en la naturaleza. ¿Por qué es tan importante la realimentación? Pues porque como veremos a continuación de forma intuitiva (la formalización de estas intuiciones se realizará en capítulos sucesivos), dota a los sistemas de unas propiedades que mejoran su funcionamiento de forma notable. El principio de la realimentación es simple: la corrección de las acciones sobre la base de la diferencia entre el rendimiento real y el deseado. En ingeniería, la realimentación ha sido redescubierta y patentada muchas veces en muchos contextos diferentes.

Robustez frente a la incertidumbre

Uno de los usos fundamentales de la realimentación es hacer al sistema robusto frente a la incertidumbre. Calculando la diferencia entre el valor medido de una señal regulada y su valor deseado, se obtiene una señal de error que puede ser usada para suministrar una acción correctiva al sistema con objeto de llevar el error a cero. Este es precisamente el concepto que explotó Watt cuando diseñó el regulador de bolas (ver sección 1.2) para regular la velocidad en las máquinas de vapor. Como un ejemplo más moderno considérese el sistema de la Figura 1.17. En él, la velocidad del vehículo se controla mediante el acelerador o el freno. Para ello el sistema de control mide la velocidad del vehículo, la cual compara el controlador (computador) con la velocidad prefijada por el conductor. Si ésta es mayor que la deseada, el sistema de control acciona el freno, y si es menor el acelerador. El gráfico de la derecha muestra que ante un cambio en la velocidad prefijada, el sistema es muy robusto frente a la incertidumbre en la masa de la planta (un número diferente de pasajeros por ejemplo), ya que a pesar de un aumento de ésta, el sistema sigue estabilizando la velocidad prefijada en aproximadamente 5 s.

| Figura 1.17. Sistema para el control de la velocidad de un vehículo. En la Figura de la izquierda se muestra el diagrama de bloques del sistema. En la Figura de la derecha se muestra la respuesta del control de velocidad ante un cambio de 25 a 30 m/s en la velocidad de consigna o deseada por el conductor. |

Otro ejemplo temprano del uso de la realimentación para proporcionar robustez en un sistema es el amplificador con realimentación negativa. El concepto de realimentación, como ya se sabe a estas alturas del texto, consiste en combinar una fracción de la salida de un sistema con su entrada. Si la fracción de señal realimentada se opone a la señal de entrada, la realimentación se denomina negativa, y si se suma a la señal de entrada se denomina positiva. Un amplificador con realimentación negativa, o más comúnmente denominado amplificador realimentado, es un amplificador que emplea realimentación negativa para mejorar sus prestaciones (estabilidad en su ganancia, linealidad, respuesta en frecuencia, respuesta a cambios en su entrada) y su robustez a las incertidumbres (variaciones en sus parámetros internos —debido a tolerancias en la fabricación o deterioros de los componentes— o externos —condiciones ambientales por ejemplo). En la Figura 1.18 se muestra el diagrama de bloques más simple de un amplificador realimentado, donde AOL es la ganancia del amplificador en lazo abierto, y la fracción (β.Salida) se realimenta a la entrada con signo menos.

El amplificador realimentado fue inventado por Harold Stephen Black (Patente americana 2.102.671 (publicada en 1937)). Black solicitó la patente en 1928, y le costó más de 9 años que fuera publicada. Black escribió más tarde: Una de las razones de la demora fue que el concepto era tan contrario a las creencias establecidas que inicialmente la Oficina de Patentes no creyó que funcionaría.

| Figura 1.18. Esquema básico de un amplificador realimentado |

Cambios en la dinámica de un sistema

Otro efecto de la realimentación es que permite cambiar la dinámica de un sistema. Esto es, su comportamiento puede ser cambiado en función de los requerimientos de una aplicación determinada: sistemas inestables pueden ser estabilizados, sistemas poco sensibles ante excitaciones pueden ser sensibilizados y sistemas con puntos de operación erráticos pueden ser mantenidos constantes. La teoría de control proporciona una colección muy rica de técnicas para analizar la estabilidad y respuesta dinámica de sistemas muy complejos, y para determinar el comportamiento de tales sistemas tanto para el caso de que puedan ser considerados lineales como no lineales.

Un ejemplo claro de cómo el control puede transformar la dinámica de un sistema se encuentra en el control del vuelo de aeronaves. Las palabras siguientes, extraídas de una conferencia impartida por Wilbur Wright en 1901, en la Western Society of Engineers, ilustra la importancia del control en el desarrollo del aeroplano.

Los hombres ya saben cómo construir alas o aviones, que cuando se impulsan por el aire a una velocidad suficiente, no sólo mantienen el peso de las alas mismas, sino también el del motor y el ingeniero. Los hombres saben también cómo construir motores y tornillos de la ligereza y potencia suficientes para llevar esos aviones a la velocidad de sustentación... La incapacidad para estabilizar y dirigir aún enfrenta a los estudiosos del problema de volar... Cuando este aspecto haya sido resuelto, la era de volar habrá llegado, dado que el resto de problemas son de menor importancia.

Los hermanos Wright se dieron cuenta enseguida que resolver el problema del control del aeroplano era un asunto clave para conseguir volar. Ellos resolvieron el compromiso entre la estabilidad y la maniobrabilidad construyendo un aeroplano, el Wright Flyer, que era inestable pero manejable. El Flyer tenía un timón en la parte delantera del avión, lo cual lo hacía muy manejable. Una desventaja era que el piloto debía estar continuamente manteniendo el timón, ya que si lo dejaba suelto el avión se estrellaba. Otros pioneros de la aviación trataron de construir aviones estables. Estos podrían haber tenido más fácil volar, sin embargo su escasa maniobrabilidad no les permitía ser conducidos por el aire. Como ya se ha indicado en este texto (ver sección 1.2), el compromiso estabilidad – maniobrabilidad que permitió hacer volar un avión por primera vez lo resolvieron los hermanos Wright en 1903.

El enorme esfuerzo que suponía para el piloto mantener estable aquellos primeros aeroplanos, generó bastante empeño en encontrar un sistema que los estabilizara de forma más o menos automática. Así, en 1912 la compañía norteamericana Sperry, basándose en el concepto de realimentación, desarrolló el primer piloto automático (Sperry autopilot). Lawrence Sperry (hijo del famoso inventor Elmer Sperry18 [15]) lo mostró dos años más tarde, en 1914, y demostró la credibilidad de su invento haciendo volar el avión mientras mantenía sus manos en alto [16]19. El piloto automático conectaba un indicador de altitud giroscópico [17]20 y una brújula magnética a un timón, elevador y alerones operados hidráulicamente. Esto permitía que el avión volase recto y nivelado respecto a una dirección de la brújula sin la atención del piloto, cubriendo así más del 80% del trabajo total de un piloto en un vuelo típico. Este piloto automático que permite seguir recto y nivelado sigue siendo el tipo más común, menos caro y más confiable. También tiene el menor error de pilotaje, al tener los controles más simples. El piloto automático es un ejemplo excelente de cómo la realimentación puede ser usada para estabilizar un sistema inestable y, consecuentemente, modificar la dinámica del avión.

Niveles más elevados de automatización

Hoy en día, el concepto de control, gracias al concurso de otras técnicas pertenecientes a otras ramas de la ciencia, fundamentalmente la inteligencia artificial, ha dado un salto cualitativo y cuantitativo que le ha permitido adentrarse en la optimización (control óptimo), adaptación (control adaptativo), aprendizaje y razonamiento (control inteligente).

Una de las áreas de investigación del control en los niveles más altos de decisión es el control autónomo de vehículos. En este campo se están realizando innumerables aportaciones, muchas de las cuales están ya en el mercado, como por ejemplo el Control de Velocidad de Crucero Adaptativo (ACC) que adapta automáticamente la velocidad del vehículo a las condiciones del tráfico.

Prueba del interés en el control autónomo de vehículos es el Darpa Grand Challenge, una carrera de vehículos autónomos21 [18] que deben llegar desde un punto de los Estados Unidos hasta otro sin intervención humana, sólo disponiendo de un listado de puntos intermedios entre el principio del circuito y el final. La primera edición se celebró en 2004 en el desierto del Mojave y ningún vehículo consiguió terminar. En 2005 varios vehículos lograron terminar el circuito, siendo el equipo de la Universidad de Stanford el ganador. La siguiente edición, conocida como 2007 Urban Challenge, introdujo una dificultad adicional, ya que se celebró en un circuito urbano donde los participantes debían obedecer las normas de tráfico y comportarse responsablemente. El ganador fue el equipo Tartan Racing de la Universidad de Pittsburgh, Pensilvania (2.000.000 $ de premio), seguido del equipo Stanford Racing de la Universidad de Stanford, California (1.000.000 $ de premio). En la Figura 1.19 se observan detalles de la carrera.

| Figura 1.19. Fotografías de la 2007 Urban Challenge. Superior izquierda: El equipo ganador de la Universidad de Pittsburgh. Superior derecha: el equipo que quedó en segundo lugar de la Universidad de Stanford. Inferior izquierda: El equipo Victor Tango de la Universidad de Blacksburg, Virginia, que quedó en tercer lugar, circulando entre 4 vehículos conducidos por personas. Inferior derecha: Los equipos de Pittsburgh y Standford juntos, en una intersección. |

Desventajas de la realimentación

Aunque la realimentación tiene muchas ventajas, también tiene algunas, aunque pocas, desventajas. La principal quizás sea que si el sistema no está bien diseñado se puede originar inestabilidad. Un ejemplo muy familiar de esto es cuando el exceso de amplificación de un micrófono, como consecuencia de la realimentación positiva, produce sonidos estridentes en una habitación. Lo anterior indica que un sistema ha de ser diseñado para que sea estable no sólo bajo condiciones nominales, sino también bajo todas las posibles perturbaciones que sufra su dinámica.

Otro problema común debido a la realimentación es el posible ruido de medida que se introduce en el sistema, de ahí que la señal medida deba ser filtrada adecuadamente, con objeto de que su posible ruido no se incorpore a la dinámica del proceso (ver Figura 1.1).

Control por anticipación (Feedforward)

El control por realimentación del error es reactivo: para que se tome una acción correctiva ha de entrar antes un error al sistema. Piénsese en un sistema de control como el de la Figura 1.17 por ejemplo. En él, se ha de seguir una señal de referencia (velocidad) fijada por el conductor. Cada vez que la referencia cambia, el sistema de control no comienza a actuar hasta que no se detecta un error entre la señal de referencia fijada y la velocidad real del vehículo. Cuanto más rápido cambie la señal de referencia menos efectiva se mostrará la acción de control, ya que parecerá que va por detrás. Lo anterior sugiere que cuando la señal de referencia cambia rápidamente, el seguimiento a tiempo puede lograrse si se tiene disponible y se utiliza una información anticipada de la referencia, tal como la velocidad de cambio (derivada) y la velocidad de cambio de segundo orden (derivada segunda o curvatura). Esta información está con frecuencia disponible en aplicaciones donde la trayectoria de referencia se planifica y almacena en la memoria del controlador (computador). A partir de aquí, el sistema de control se puede adelantar y tomar alguna acción correctiva antes de que el cambio en la referencia a seguir genere un error en la salida. Evidentemente, en el momento del cambio siempre se generará un error, por pequeño que sea, lo que ocurre es que el sistema de control lo anulará mucho más rápidamente. Esta forma de control se denomina por anticipación, en inglés feedforward.

Las ideas de control por realimentación y control por anticipación son muy generales y aparecen en campos muy diversos. En economía, un control por realimentación puede ser asociado a una economía basada en la respuesta del mercado, y un control por anticipación a una economía basada en planificación. En biología, una estrategia de control por anticipación es un principio fundamental en el control del movimiento de las personas y animales, el cual, durante la infancia, es ajustado mediante entrenamiento. En general, la mayor efectividad de control se logra cuando realimentación y anticipación (no siempre es posible) se aplican de forma conjunta.

1.1 Prepare, si no lo domina, el capítulo 1 del manual docente: Andújar J. M., et al. Guía práctica de simuladores de circuitos y sistemas electrónicos II. Servicio de Publicaciones de la Universidad de Huelva, ISBN 84-95699-16-8, 2001. Realice todos los ejercicios resueltos, ya que MATLAB será una herramienta de uso constante en la signatura.

1.2 Prepare, si no lo domina, el capítulo 2 del manual docente: Andújar J. M., et al. Guía práctica de simuladores de circuitos y sistemas electrónicos II. Servicio de Publicaciones de la Universidad de Huelva, ISBN 84-95699-16-8, 2001. Es importante que se familiarice con las posibilidades de SIMULINK (la versión más moderna que seguro utilizará respecto de la explicada en el texto ofrecerá muchas más prestaciones), ya que será una herramienta de uso continuo en la asignatura.

1.3 Busca en Internet una animación de la suspensión cardan y explica sus funcionamiento. A partir de aquí intenta razonar el funcionamiento del giróscopo.

1.4 Identifique 5 sistemas de control presentes en su entorno diario. Para cada uno de los sistemas identifique los mecanismos que hacen el sensado y la actuación, así como la ley de control. Identifique también respecto de qué incertidumbres proporciona robustez el sistema de control y/o la modificación de la dinámica del sistema que se consigue con la realimentación.

1.5 Manténgase en equilibrio sobre un pie con los ojos cerrados durante 15 segundos. Usando la Figura 1.1 como guía, describa el sistema de control responsable de que no se caiga. Por supuesto, la arquitectura del controlador tendrá otra concepción en este caso respecto de la presentada en la Figura 1.1.

1.6 Realice una búsqueda en la red y localice un artículo de prensa divulgativa sobre algún sistema de control. Describa, a partir de la terminología usada en el artículo, el sistema. De forma específica identifique el sistema de control y describa: (a) la planta controlada, junto con el (b) sensor, (c) actuador y (d) elementos de computación. Si alguna información no estuviera disponible en el artículo, coméntelo y proponga, según su opinión, qué podría usarse.

Al igual que hace el Control de Velocidad de Crucero, el Control de Velocidad de Crucero Adaptativo (ACC) también regula la velocidad a la que deseamos circular de forma automática. La novedad reside en que además, con la ayuda de un sistema de radar controla, también de forma automática, la distancia de circulación con respecto al vehículo precedente, frenando nuestro vehículo si es necesario para mantener dicha distancia de seguridad. Una vez que el carril por el que circulamos queda libre, el ACC acelera el vehículo hasta la velocidad que hayamos programado.

El control de tracción (EDS del inglés Electronic Differential System) busca la mejor motricidad del vehículo para evitar el patinado de los neumáticos sobre firme deslizante o bajo una fuerte aceleración. Su función es conseguir que las ruedas motrices se muevan a la misma velocidad. Para ello utiliza la instalación de freno y aprovecha el sistema ABS para su funcionamiento.

El control de estabilidad (ESP del alemán Elektronisches Stabilitätsprogramm) mejora el EDS en el sentido que éste sólo evita que se produzcan pérdidas de motricidad por exceso de aceleración, y no es capaz de recuperar la trayectoria del vehículo en caso de excesivo subviraje o sobreviraje, lo cual sí consigue el ESP. Este sistema fue desarrollado originalmente por Mercedes-Benz y Bosch, y hoy en día lo desarrollan y comercializan otros fabricantes con nombres como Vehicle Dynamic Control (VDC), Dynamic Stability Control (DSC), Electronic Stability Control (ESC) y Vehicle Stability Control (VSC).

Alas pequeñas (fijas o movibles) que son colocadas antes de las alas principales del avión. En inglés se denominan canards

Fly-by-wire, traducido literalmente del inglés como vuelo por cable, es un sistema de control de las superficies de sustentación o de dirección de un avión, que se basa en el uso de servomotores que, mediante impulsos eléctricos activados por computadora, desplazan fluido hidráulico hasta aquellas. Es este último el que finalmente termina realizando los efectivos movimientos y ajustes necesarios en tiempo real. De esa manera indirecta se mueven las diferentes superficies de vuelo, como son el timón de dirección, el de profundidad (elevator), los alerones, los flaps (situados en el borde de fuga de las alas permiten mediante su giro aumentar la superficie de sustentación), los slats (situados en el ángulo de ataque de las alas permiten modificar éste) o el freno aerodinámico. Los controles fly-by-wire fueron incorporados en aviones militares estadounidenses ya en la década de 1970, como sucedió en los casos del F-16 Fighting Falcon, el F/A-18 Hornet y el F-15 Eagle. Por su parte, el francés Mirage 2000, lanzado en 1978, también los incluye.

La Heliopausa es el punto en el que el viento solar se une al medio interestelar o al viento estelar procedente de otras estrellas. Es un límite teórico aproximadamente circular o en forma de lágrima, que señala el límite de influencia del Sol. Se localiza en el punto en el que la pérdida de presión del viento solar causada por la dispersión inherente a su difusión radial iguala a la presión exterior del medio interestelar. La Heliopausa señala la frontera entre el Sistema Solar y el espacio interestelar.

El control en la industria química suele denominarse con el nombre genérico de control de procesos.

Se trata en pocas palabras de aprovechar el calor generado en un proceso químico para producir también electricidad. Al generar electricidad mediante un alternador, movido por un motor térmico o una turbina, el aprovechamiento de la energía química del combustible es del 25% al 40% solamente, y el resto debe disiparse en forma de calor. Con la cogeneración se aprovecha una parte importante de la energía térmica que normalmente se disiparía a la atmósfera o a una masa de agua y evita volver a generarla con una caldera.

Backscatter o backscattering es la reflexión de ondas, partículas, o señales en sentido opuesto al de avance.

La espectroscopia Raman (llamada así por C.V. Raman) es una técnica espectroscópica usada en química y física de la materia condensada para estudiar modos de baja frecuencia como los vibratorios, rotatorios, y otros. El efecto de Raman se produce cuando la luz choca sobre una molécula e interacciona con la nube de electrones de los enlaces de esa molécula.

La macroeconomía es la parte de la economía encargada del estudio global de la economía en términos del monto total de bienes y servicios producidos, el total de los ingresos, el nivel de empleo, de recursos productivos, y el comportamiento general de los precios. La macroeconomía puede ser utilizada para analizar cuál es la mejor manera de influir en objetivos políticos como por ejemplo hacer crecer la economía, estabilidad de precios, trabajo y la obtención de una sustentable balanza de pagos.

La microeconomía es una parte de la economía que estudia el comportamiento económico de agentes individuales, como son los consumidores, las empresas, los trabajadores e inversores; así como de los mercados. Considera las decisiones que toma cada uno para cumplir ciertos objetivos propios. La microeconomía tiene varias ramas de desarrollo, las más importantes son: la teoría del consumidor, la de la demanda, la del productor, la del equilibrio general, y la de los mercados de activos financieros. No pueden considerarse enteramente separadas porque los resultados de unos aspectos influyen sobre los otros. Por ejemplo, las empresas no sólo ofertan bienes y servicios, sino que también demandan bienes y servicios para poder producir los suyos.

El término justo a tiempo es una traducción de la expresión inglesa just-in-time, la cual da nombre a un sistema de organización de la producción para las fábricas denominado método Toyota o JiT. Las compañías japonesas que durante los últimos años han adoptado este método han aumentado su productividad en los últimos 20 años.

Un anticuerpo monoclonal es un anticuerpo homogéneo producido por una célula híbrida producto de la fusión de un clon de linfocitos B, descendiente de una sola y única célula madre y una célula plasmática tumoral. Los anticuerpos monoclonales (MAB, del inglés monoclonal antibody), son anticuerpos idénticos porque son producidos por un solo tipo de célula del sistema inmune, es decir, todos los clones proceden de una sola célula madre. Es posible producir anticuerpos monoclonales que se unan específicamente con cualquier molécula con carácter antigénico (un antígeno es una sustancia que, introducida en un organismo animal, da lugar a reacciones de defensa, tales como la formación de anticuerpos). Este fenómeno es de gran utilidad en bioquímica, biología molecular y medicina.

Las células hybridoma son células que han sido diseñadas para producir un anticuerpo concreto en grandes cantidades. Éstas células, al ser cancerígenas, se multiplican rápida e indefinidamente, produciendo enormes cantidades del anticuerpo deseado.

La dinámica de sistemas es una metodología considerada por muchos autores como parte de la automática. Está dedicada a la construcción de modelos de simulación para sistemas complejos como los estudiados por las ciencias sociales, la economía o la ecología. Quizás, la principal característica de estos modelos es que sus elementos están relacionados formando lazos de realimentación.

En bioquímica, una metaloproteina es un término genérico que alude a una proteína que contiene un metal como componente químico.

Prolífico inventor y hombre de negocios norteamericano, autor de más de 400 patentes. Nació en 1860 en Cortland, Nueva York, y murió en 1930 en Brooklyn, Nueva York. Sperry diseñó un girocompás (patentado en 1908), instalado por primera vez en el acorazado norteamericano Delaware en 1911, que permite pilotar de forma automática y fiable aviones, barcos y hasta naves espaciales.

Esto lo hizo en el Concours de la Securité en Aéroplane (concurso de la seguridad en aeroplano) que se celebró en las orillas del río Sena el 18 de junio de 1914.

El giroscopio fue inventado en 1852 por Léon Foucault, quien también le dio el nombre, montando una masa rotatoria en un soporte de Cardano (el soporte denominado Cardán, del francés cardan, por alusión a su inventor, el italiano Girolamo Cardano, 1501-1576, es un mecanismo de suspensión, consistente en dos círculos concéntricos cuyos ejes forman ángulo recto, que permite mantener la orientación de un eje de rotación en el espacio aunque su soporte se mueva) para un experimento de demostración de la rotación de la tierra. La rotación ya había sido demostrada con el péndulo de Foucault. Sin embargo, Foucault no comprendía el por qué la velocidad de rotación del péndulo era más lenta que la velocidad de rotación de la tierra por un factor sen λ, donde λ representa la latitud en que se localiza el péndulo. Se necesitaba otro aparato para demostrar la rotación de la tierra de forma más simple. Foucault presentó así un aparato capaz de conservar una rotación suficientemente rápida (150 a 200 vueltas por minuto) durante un tiempo suficiente (una decena de minutos) para que se pudiesen hacer medidas. Esta proeza mecánica (para la época) ilustra el talento de Foucault y su colaborador Froment en mecánica. Foucault también se dio cuenta de que su aparato podía servir para indicar el Norte. En efecto, si se impiden ciertos movimientos del soporte del giroscopio, este se alinea con el meridiano. Esto permitió la invención del girocompás.

Un vehículo autónomo terrestre es un vehículo que navega y se conduce por sí mismo sin intervención humana, ni siquiera por control remoto. Mediante el uso de sensores y sistemas de posicionamiento, el vehículo determina todas las características requeridas de su entorno así como las acciones a realizar para poder cumplir la tarea que se le ha asignado.

Enlaces:

[1] http://uhu.es/antonio.barragan/content/1

[2] http://uhu.es/antonio.barragan/content/2

[3] http://uhu.es/antonio.barragan/content/3

[4] http://uhu.es/antonio.barragan/content/4

[5] http://uhu.es/antonio.barragan/content/5

[6] http://uhu.es/antonio.barragan/content/6

[7] http://uhu.es/antonio.barragan/content/7

[8] http://uhu.es/antonio.barragan/content/8

[9] http://uhu.es/antonio.barragan/content/11

[10] http://uhu.es/antonio.barragan/content/12

[11] http://uhu.es/antonio.barragan/content/13

[12] http://uhu.es/antonio.barragan/content/14

[13] http://uhu.es/antonio.barragan/content/16

[14] http://uhu.es/antonio.barragan/content/17

[15] http://uhu.es/antonio.barragan/content/18

[16] http://uhu.es/antonio.barragan/content/19

[17] http://uhu.es/antonio.barragan/content/20

[18] http://uhu.es/antonio.barragan/content/21